「生成AIは便利だけど、お金がかかる」「データを外に送るのは不安」と思っていませんか?

そんな方におすすめなのが、Gensparkブラウザの「On-Device Free AI」です。

インストールしてモデルを選ぶだけで、あなたのPCがそのままAI環境に変わります。

しかも完全無料・ローカル処理・オフライン対応。

目次

ローカルで無料&使い放題

Genspark On-Device Free AIを使えば、生成AIを 自分のPCだけ で動かせます。

- ✅ 完全無料(サブスクやクレジット消費なし)

- ✅ サーバー通信なし(データは外に出ない)

- ✅ オフラインでも動作(ネットがなくても利用可能)

つまり「セキュリティもコストも心配なし」で生成AIを使い放題です。

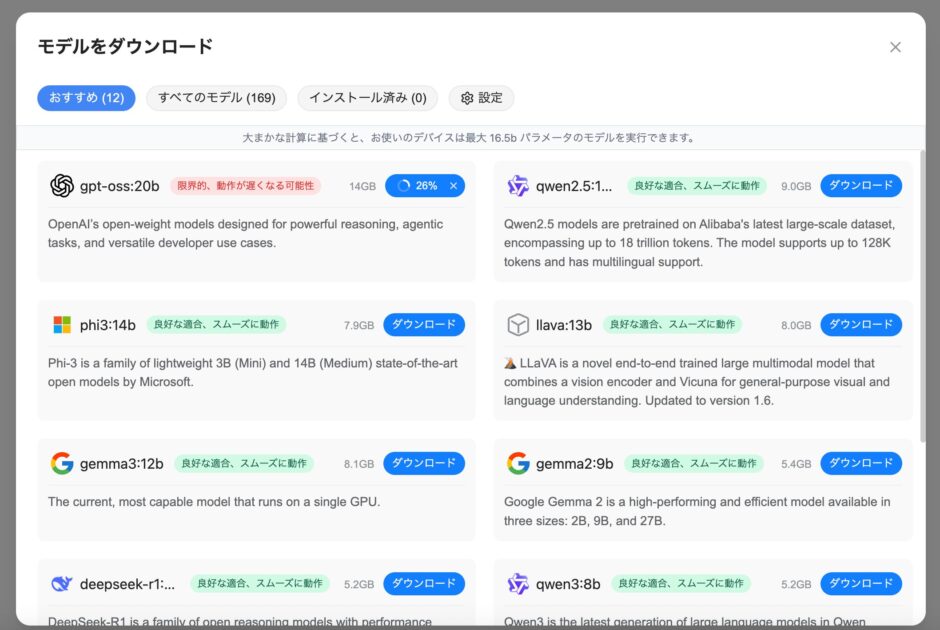

選べるAIモデルは169種類!

169個のオープンモデルが選択できます。

その中でも、おすすめされているのが次の12モデルです。

おすすめモデル12選

- gpt-oss:20b(OpenAI OSS)

大規模(20Bパラメータ)の汎用モデル。高度な推論力を持つが、容量14GBと重め。 - qwen2.5:14b(Alibaba)

多言語対応に強く、日本語も扱える。128Kトークンまで対応。9GB。 - phi3:14b(Microsoft)

軽量設計の高性能モデル。文章生成が得意で初心者でも扱いやすい。7.9GB。 - llava:13b

画像理解もできるマルチモーダルモデル。テキスト+画像を組み合わせた応用に便利。8GB。 - gemma3:12b(Google)

最新世代の高性能モデル。記事作成や学習向けに自然な文章を生成。8.1GB。 - gemma2:9b(Google)

効率的で軽量なモデル。コストを抑えつつ十分な精度を確保。5.4GB。 - deepseek-r1:7b

論理的な推論や数理的な課題に強み。動作も比較的軽快。5.2GB。 - qwen3:8b(Alibaba)

Qwenシリーズ最新世代。日本語対応も改善され、幅広い用途に対応。5.2GB。 - llama3.1:8b(Meta)

Llama 3 系列の中規模モデル。最新の自然言語処理技術を搭載。4.9GB。 - llama3:8b(Meta)

オープンソース界隈で人気のモデル。精度と軽さのバランスが良い。4.7GB。 - mistral:7b(Mistral AI)

軽量で高速。コンパクトながら性能が高く、幅広いタスクで安定。4.4GB。 - llama3.2:3b(Meta)

とても軽量(2GB)の入門モデル。ノートPCなどスペックが限られる環境でも動作可能。

どれを選べばいい?

- 軽量で試しやすい → llama3.2:3b、mistral:7b

- 中規模で万能 → gemma2:9b、qwen3:8b、phi3:14b

- 大規模で高性能 → gpt-oss:20b、gemma3:12b

まずは軽量モデルから始め、慣れてきたら中規模や大規模モデルに挑戦すると安心です。

使い方はとてもシンプル

- Gensparkブラウザをインストール

- 好きなAIモデルをダウンロード

- すぐにチャット画面でAIと会話開始

難しい設定やコマンド操作は一切不要です。

オフラインでも安心して使える

インターネット接続がなくてもOK。

飛行機の中や電波の届かない場所でもAIが使えるので、出先でも安心です。

内部の仕組み(ちょっと専門的な話)

Gensparkブラウザが「無料・ローカル・オフライン」を実現できるのは、この仕組みに理由があります。

- AIモデルをダウンロードしてPCに保存

一度保存すれば以降はネット接続不要。 - 推論(生成処理)はPC内部で完結

モデルをメモリ(RAM)にロードし、入力テキストをトークン化してニューラルネットワークで処理。 - GPUがあれば高速化

CPUだけでも動くが、GPUを搭載しているとより快適。 - 外部サーバーには一切送信しない

クラウド型サービスのようにデータが外部に流れることはなく、完全プライベート。

注意点(正直に伝えておきたいこと)

- 大規模モデルはPCスペック(特にメモリ・GPU)に依存

- 商用AIに比べると精度が落ちることがある

- モデルサイズが大きいので、ストレージ容量をある程度確保しておく必要あり

あなたのPCに「無料のAI環境」を

- 完全無料・使い放題

- ローカル処理で安全

- オフライン対応で便利

- 169種類のモデルから選べる(特におすすめ12モデル)

Gensparkブラウザを使えば、インストールしてモデルをダウンロードするだけで、すぐに手元でAIを動かせます。

あなたのPCを「無料のAI環境」に変えて、オフラインでも安心して生成AIを活用してみませんか?